井口博士のサイトより

https://quasimoto4.exblog.jp/33263830/

<転載開始>

みなさん、こんにちは。弥栄!

<転載終了>

https://quasimoto4.exblog.jp/33263830/

<転載開始>

みなさん、こんにちは。

いや〜〜、さっき偶然みた苫米地先生の「ChatGPTの問題点とその解決法」の解説は非常に興味深かった。これである。

非常に話が数学的だったので、実によくわかった。

むろん、細かいところはわからないが、やっていることおよびやろうとしていることはよくわかった。

要するに、いまちまたで「AI」と言っているのは、[quasi AI]=「準AI」、つまり「AIもどき」であって、本物のAIではないので、

「AI」は知らずに困った場合に

「AI」は嘘を付く

というのである。

この問題をどうやって解決するか?

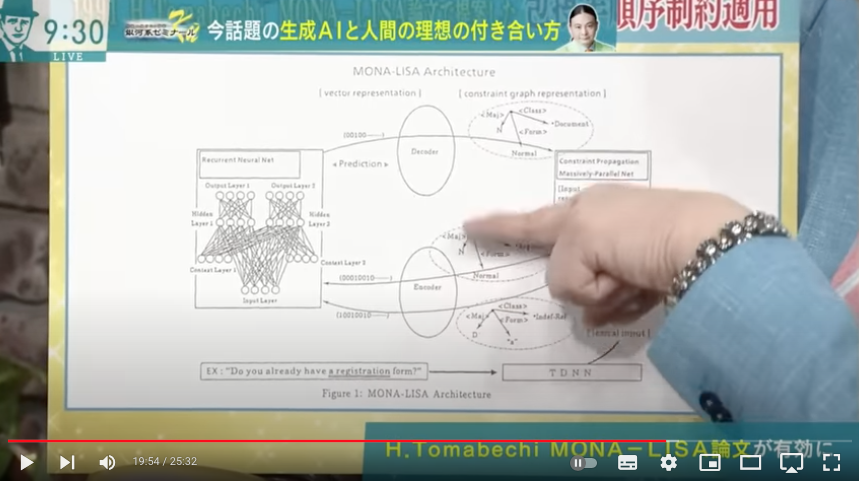

これをすでに1991年の論文で、苫米地英人博士は解決済みだった。

そしてすでに32年経っているから、それを解決するアプリも開発済みだったという落ちであった。

要するに、ChatGPTは「生成AI」というものであるが、その「AI」の部分が「AIモドキ」であるために、ChatGPTもまた「AIモドキ」なのである。

また、いまの「AI」は「AIモドキ」だということに関しては、オタッキングの岡田斗司夫さんもいろいろ詳しく語っている。これだ。

つまり、いまちまたで「AI」と呼ばれている技術は、実際には膨大なデータを統計的に処理した結果を表示するだけのものである。

だから、その広さと深さが膨大だというだけで、Deep learningと言う言葉がつく。

しかし、我々人間がやっているような知的活動とは異なる。

ゆえに、「AI」は人間の行う知能のコピーではないということである。

単にコンピュータチップの性能が昔のものより何億倍にも増した結果、人間の処理できる情報量を遥かに超えたスーパースーパービッグデータの情報量の世界で計算できるというだけのものであるというわけですナ。

そして、苫米地先生が指摘するそんな「AI」の問題点とは?

「AI」=ChatGPTは嘘つきだ

ということになる。

なぜか?

というと、いくら処理できる膨大な情報量を持つといってもそれはいまなら2021年までの知識、2023年までのリアルタイムの知識ではない。

つまり、ChatGPTにはタイムラグがある。

この2021年から2023年までの2年間の知識はまだ入力されていないから、この間に現れた、この間に起こった事件や出来事や文章やその他諸々の知識は欠落する。

だから、いまの話に対しては、「AI」はそれらしい嘘をついてくる。

どうやら、苫米地人博士は、この問題を早くも1991年までに気づくという先見の明を持っていた。

そしてそれを1991年に解決済みだったというわけだ。

私にはこの部分が非常に興味深かった。この部分である。

要するに、我々人間の思考というものは、単にすべての単語や語句などの情報を同列に並べて覚えているわけではない。

単語や情報には抽象度の序列がある。

そして、抽象度の序列の階層構造ができている。

抽象度を1つ上げると、それまでの下位構造の中の情報の間の矛盾や相違の関係は無関係になる。

たとえば、ウクライナとロシアはいま戦争しているが、この階層の中では両者は関係が悪い。

しかし、思考の抽象度をワンランクあげて、白人と黒人と黄色人種というような抽象度でいうと、ウクライナ人もロシア人も白人の国だから、ウクライナとロシアの戦争のことはどうでもよくなってしまう。

さらに、ヨーロッパ人と東洋人という抽象度で考えれば、ウクライナとロシアの戦争状態はどうでもよくなる。

つまり、人間の思考には抽象度のレベルによって考えるという構造がある。

ところが、ChatGPTはそれがない。

「AI」の行うニューラルネットワークの階層構造はそういうものではない。

そこで、ChatGPTの部分に人間の思考に近いアシストソフトを組み込んで、ChatGPTの計算を外部から制御するという、最適制御理論に似たようなことを行えば、非常によく修正可能だということを苫米地英人博士が提唱したということらしい。この部分である。

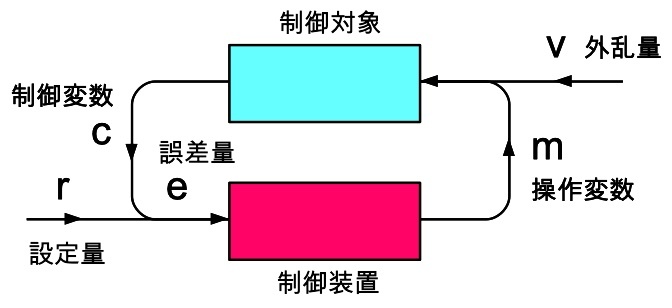

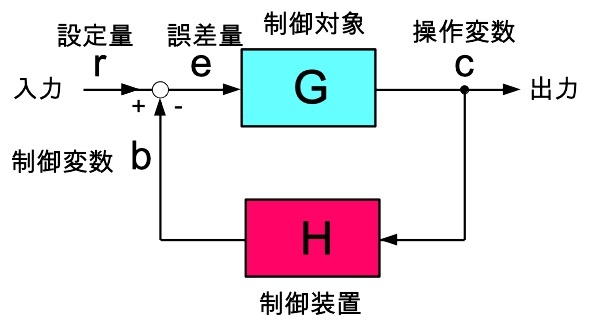

これって、本当に工学分野でよく知られた最適制御理論の制御構造によく似ている。

私の本「非線型力学入門(下)」の中の図でいえば、こんなやつ。

この「制御対象」の中にChatGPTを入れ、「制御装置」の中に苫米地アプリを入れたと思えば良い。

要するに、ChatGPTの暴走を止めるには、制御装置を使って最適制御すればよろしい、ということになる。

この制御装置の部分に人間の思考に基づく、一種の「常識」を入れる。

まあ、こうすると、非常に人間らしくなって平凡になってしまうかもしれないが、

ユダヤ人のようなChatGPT→日本人のようなChatGPT

に変わるだろう。

さて、この話をどうやら苫米地先生は、明日5月20日に神奈川大学で行うらしい。

神奈川大学 情報学部開設記念シンポジウム2023

情報学分野をリードする有識者によるシンポジウム

5月20日(土)13時〜 神奈川大学横浜キャンパスにて開催

参加無料

https://www.kanagawa-u.ac.jp/news/det...

いいなあ、関東の人は。

おまけ:

ChatGPTは過去のデータ処理に対しては人間を超越している。

そこで、ChatGPTに

次のロト7の当選番号を予想してください!

と入力したらどうか?

これで10億円が当選するようになった場合、どうするのか?

それにしても苫米地先生はすごい。やはり正真正銘の天才だったんですナ。

恐れ入りました。

苫米地英人先生に、座布団1億枚!

いやはや、世の始まりですナ!

<転載終了>

コメント